94

随着视频内容的激增,我们需要有效且灵活的神经网络方法来生成新的视频内容。在这篇文章中,研究人员提出了一种新颖的方法,结合零射击文本到视频生成和ControlNet,以提高这些模型的输出。

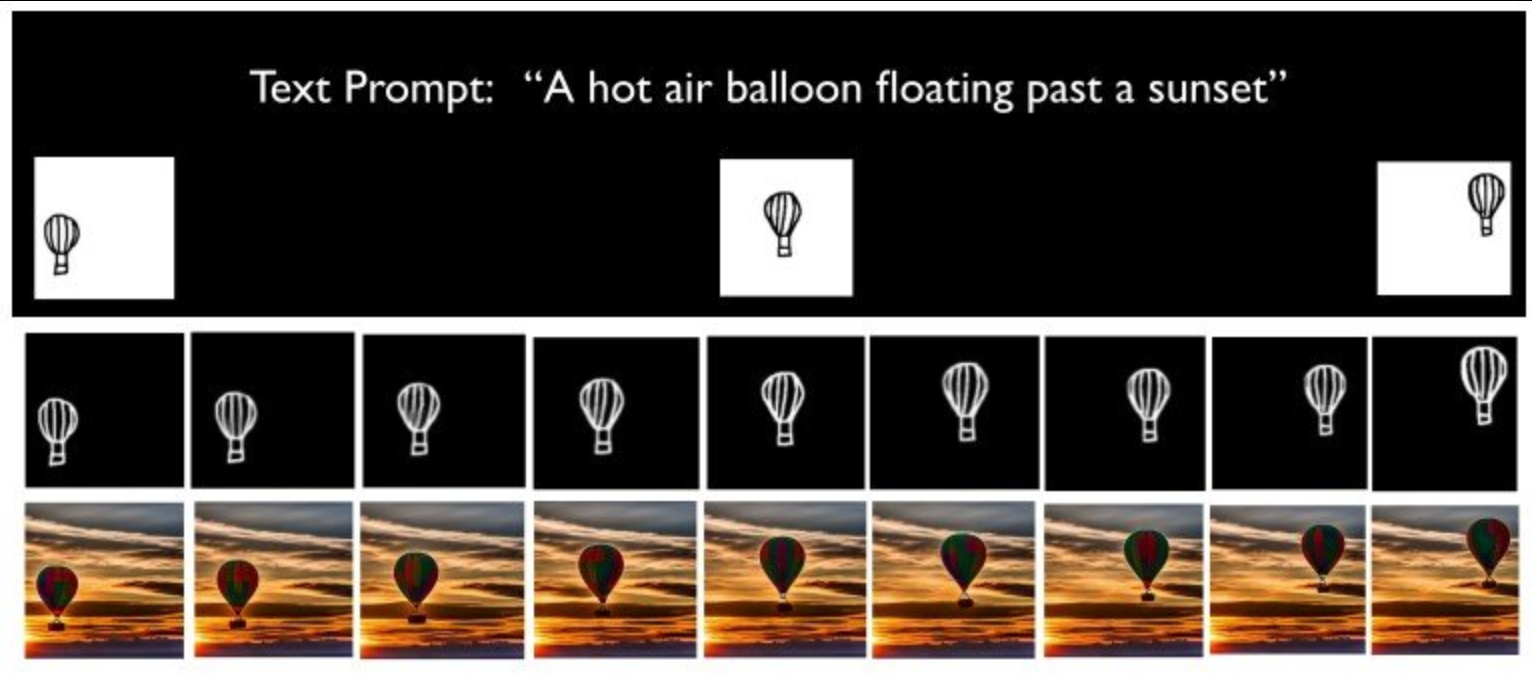

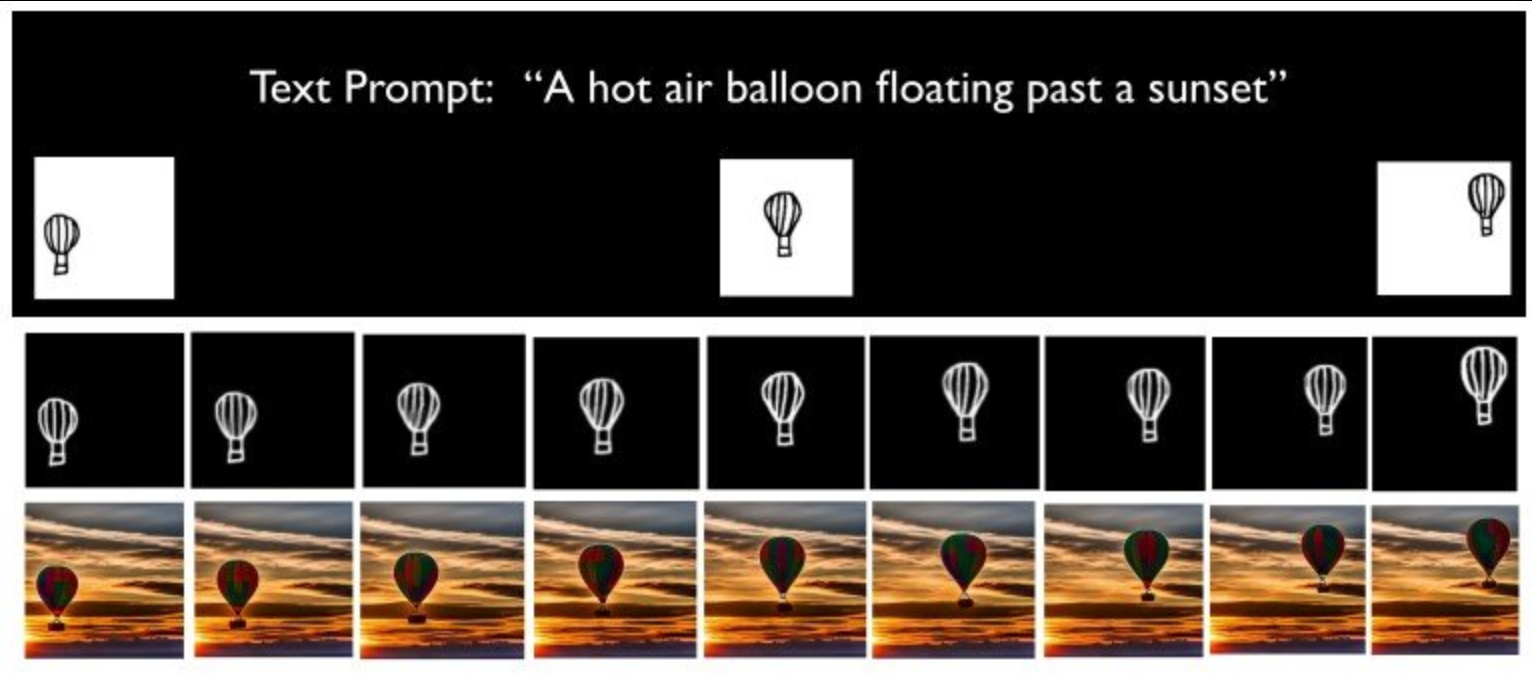

这种方法的主要特点是,它接受多个草图帧作为输入,并生成与这些帧流动匹配的视频输出。这种方法基于Text-to-Video Zero架构,并结合ControlNet以启用额外的输入条件。

首先,研究人员在输入的草图之间插值帧,然后使用新插值帧视频作为控制技术运行Text-to-Video Zero。这样,我们就可以利用零射击文本到视频生成和ControlNet提供的强大控制的优点。

实验表明,该研究方法擅长产生高质量且极其一致的视频内容,这些内容更准确地与用户对视频主题的预期动作相符。项目提供了一个全面的资源包,包括演示视频、项目网站、开源GitHub仓库和一个Colab游乐场,以促进提出的方法进一步得到研究和应用。

参考资料: